Produktportfolio

Fachbeitrag

Übersicht über grüne Energiestrategien und -techniken für moderne Rechenzentren

WP0014_de-de

Autor:

Delta Power Solutions

Thematisiertes Produkt:

Rechenzentren-Lösungen

Einführung

Rechenzentren stellen den Betrieb geschäftskritischer IT-Geräte sicher, einschließlich Server-, Netzwerk- und Speichergeräte. Da Rechenzentren Milliarden Internetnutzer auf der ganzen Welt unterstützen, ist der damit verbundene Energieverbrauch erheblich. Um wesentliche Energieeinsparungen zu erzielen, ist somit eine spürbare Verbesserung ihrer Energieeffizienz erforderlich. Die Betreiber vorhandener Rechenzentren müssen bei der Verwaltung ihrer Rechenzentren auf eine hohe Effizienz hinarbeiten, um sowohl im Hinblick auf „Wirtschaftlichkeit“ als auch „Umweltfreundlichkeit“ zu punkten.

Der erste Schritt zur Verbesserung der Energieeffizienz von Rechenzentren ist eine sorgfältige Prüfung des PUE-Werts (Power Usage Effectiveness). Vereinfacht gesagt ist der PUE-Wert der Gesamtstromverbrauch eines Rechenzentrums dividiert durch den IT-Stromverbrauch oder die der gesamten Infrastruktur zugeführte Energiemenge dividiert durch die von den IT-Geräten benötigte Energiemenge. Die Kennzahl PUE wurde von einer von der Vereinigung Green Grid einberufenen Arbeitsgruppe definiert, die aus Vertretern von Regierungsorganisationen und Branchenführern bestand. Da sie ein sehr verlässlicher Maßstab für die Messung der Energieeffizienz von Rechenzentren ist, kann sie auf alle Standard-Rechenzentren angewendet werden. Ziel ist es, einen „konsistenten und wiederholbaren Indikator“ zu etablieren, den die Betreiber von Rechenzentren für eine ständige Kontrolle und Verbesserung ihres Energieverbrauchs heranziehen können. In einer vom Uptime Institute 2014 durchgeführten Untersuchung wurde ein branchenweiter PUE-Wert von durchschnittlich 1,7 ermittelt. Dieser lag über der Kennzahl von 1,67 im Jahr 2013, aber unter dem Wert von 1,8 aus dem Jahr 2012, was darauf hinweist, dass bei der Energieeffizienz von Rechenzentren weiterhin Verbesserungspotenzial besteht (siehe Abb. 1).

Abbildung 1: Durchschnittlicher PUE-Wert für Rechenzentren, 2011 ~ 2014

Quelle: Ergebnisse des Data Center Industry Survey 2014 vom Uptime Institute

Durch den Siegeszug von Big Data und dem Internet der Dinge (Internet of Things, IoT) wurden in den letzten Jahren immer mehr Rechenzentren erbaut. Wachsendes Umweltbewusstsein hat zudem die Bedeutung von „Energieeinsparungen in Rechenzentren“ in den Fokus gerückt. Zunächst einmal machen die Energiekosten nach den Personalkosten den zweitgrößten Posten bei den Gesamtbetriebskosten (TCO) von Rechenzentren aus. Rechenzentren wird außerdem häufig „mangelnde Umweltfreundlichkeit“ vorgeworfen (siehe von Greenpeace veröffentlichte jährliche Bewertungen). In Wirklichkeit aber sind Rechenzentren beispielsweise in den USA nur für 2 % des Gesamtenergieverbrauchs verantwortlich und liegen damit unter dem weltweiten Durchschnitt. Das zeigt, dass viele Rechenzentren immer noch sehr unterschiedlich vorgehen, um den Energieverbrauch und den Ausstoß von Kohlendioxid zu senken.

Noch haben viele Rechenzentren jedoch keine Effizienzkennzahlen eingeführt, daher gibt es keinen Standard für Energieeinsparungen. Trotz der anhaltenden Diskussionen über den PUE-Wert handelt es sich doch um die primäre Methode zur Messung der Effizienz von Rechenzentrumsinfrastruktur und einen hilfreichen Referenzwert für die Entwicklung und Ausführung ökologischer Strategien für Rechenzentren.

Grüne Strategien für Rechenzentren

Laut dem Artikel „Characteristics of Low Carbon Data Centres“, der im Nature Climate Change, veröffentlicht wurde, sind die Energieeffizienz und Kohlendioxidemissionen von IT-Geräten, wie beispielsweise Server, Speicher, Kommunikationsgeräte und Infrastruktur (Lüfter, Kühlanlagen, Pumpen, Beleuchtung) Schlüsselfaktoren bei der Produktion von Treibhausgasen durch Rechenzentren. Der Artikel führt verschiedene Verbesserungsvorschläge für eine Senkung des Energieverbrauchs an, die einen erheblichen Unterschied für grüne Rechenzentrumsprojekte machen können.

Im Folgenden werden die sieben wichtigsten grünen Strategien für Rechenzentren beschrieben. Mit ihrer Hilfe lässt sich der Energieverbrauch in Rechenzentren senken und der PUE-Wert optimieren:

Strategie 1: Regelmäßige Überprüfung der Hardware

Globale IT-Giganten wie Facebook, Google und Apple sind ständig auf der Suche nach weiteren Möglichkeiten zur Verbesserung ihrer Rechenzentrumseffizienz. Auch wenn ihre Methoden vielleicht sehr beeindruckend wirken, wird zuerst eine Strategie vorgeschlagen, die für fast alle Unternehmen machbar ist: eine routinemäßige Prüfung der gesamten vorhandenen Hardware.

In Rechenzentren sammeln sich üblicherweise viele unnötige IT-Geräte an. Als „komatöse Server“ werden Server bezeichnet, die immer noch im Rack angeschlossen sind, aber nicht länger aktiv verwendet werden. Sie nehmen wertvollen Platz im Rack in Beschlag, verbrauchen große Energiemengen und erhöhen den PUE-Wert. Das Uptime Institute hat 2013 eine Untersuchung durchgeführt, um herauszufinden, wie verbreitet dieses Problem ist. Das Ergebnis war, dass die Hälfte der Befragten keine systematischen Prüfungen oder die Außerbetriebnahme von nicht benötigen Server durchführt. Eine Stichprobenerhebung der US-amerikanischen Umweltbehörde EPA (Environmental Protection Agency) ergab außerdem, dass die meisten Rechenzentren über keine effektiven Mittel zur Überwachung ihrer Infrastruktur- und IT-Last vor Ort verfügen. Diese Rechenzentren haben also noch einen weiten Weg vor sich, bis ihr Energieverbrauch entscheidend verbessert ist.

Die Barclays Bank konnte beispielsweise Einsparungen bei Energie, Kühlung und Rack-Fläche erzielen, nachdem sie 2013 insgesamt 9.124 nicht benötigte Server aussortiert hatte. Die Rechenleistung wurde erhöht und die Stromrechnung konnte um 4,5 Millionen US-Dollar gesenkt werden. Eine Reduzierung der Serverzahl bringt daher deutliche Vorteile mit sich.

Neben einer Prüfung der IT-Geräte müssen auch nicht zur IT-Infrastruktur gehörende Geräte wie zum Beispiel die unterbrechungsfreien Stromversorgungen (USV) des Rechenzentrums regelmäßig überprüft werden. Der aktuelle Trend geht nicht mehr zu konventionellen Trafo-basierten Monoblock-USV, sondern zu transformatorlosen modularen USV. Um Energieeinsparungen im Rechenzentrum zu erzielen, sollten die beiden folgenden Faktoren bei der Auswahl einer USV berücksichtigt werden:

-

Skalierbarkeit: Mit modularen USV kann die Anzahl an Stromversorgungsmodulen erhöht werden, um mit der Erweiterung des Rechenzentrums Schritt zu halten. Bei der Einrichtung des Serverraums sind keine großen Kapitalinvestitionen erforderlich und es wird auch kein zusätzlicher Platz benötigt. Auf diese Weise ist bei einem weiteren Wachstum des Servergeschäfts eine „nahtlose Erweiterung“ der USV möglich (Abb. 2). Neben zusätzlichen Leistungsmodulen müssen USV auch mehrere parallel betriebene Geräte unterstützen, damit eine Kapazitätserweiterung möglich ist.

Abbildung 2: Modulare USV für die nahtlose Erweiterung des Rechenzentrums -

Hoher Wirkungsgrad bei geringer Last: In Rechenzentren werden normalerweise Stromversorgungen mit N+X-Redundanz oder sogar 2N-Konfigurationen (Dual BUS) installiert, um einen zuverlässigen Betrieb garantieren zu können. Das bedeutet, dass der Prozentsatz der Last normalerweise etwa 30 ~ 40 % oder sogar noch weniger ausmacht. Die für eine „Volllast“ der USV ausgewiesenen hohen Effizienzwerte sind daher kaum realistisch. Laut einem Bericht des Marktforschungsinstituts Gartner 2013 ist neben dem USV-Wirkungsgrad bei Volllast besonders auf den Verlauf der Wirkungsgradkurve (siehe Abb. 3) bei einer Last zwischen 20 ~ 100 % zu achten, um den Idealzustand von „hohem Wirkungsgrad bei geringer Last“ zu erkennen. Nehmen wir beispielsweise eine modulare USV mit einem hohen Wirkungsgrad und einer Kapazität von 200 kVA. Wenn die Lastunterschiede im Rechenzentrum für Tag und Nacht berücksichtigt werden, dann verbraucht eine hocheffiziente USV rund 5 % weniger Strom als eine konventionelle USV.

Abbildung 3: USV-Wirkungsgradkurve

|

Beispiel-USV mit 200kVA |

Modulare hocheffiziente USV |

Veraltete USV |

|

|

Tagsüber gelieferter Strom, 50 % Last |

100 |

100 |

kW |

|

Zusätzliche Verluste aus der Wirkungsgraddifferenz |

0% |

4% |

|

|

Gesamtverbrauch |

100 |

104 |

kW |

|

Tagesverbrauch bei 14 Stunden |

1,400 |

1,456 |

kWh |

|

Nachts gelieferter Strom, 30 % Last |

60 |

60 |

kW |

|

Zusätzliche Verluste aus der Wirkungsgraddifferenz |

0% |

7% |

|

|

Gesamtverbrauch |

60 |

64.2 |

kW |

|

Nächtlicher Verbrauch bei 10 Stunden |

600 |

642 |

kWh |

|

Tagesverbrauch (Tag und Nacht) |

2,000 |

2,098 |

kWh |

|

Jahresverbrauch, 365 Tage |

730,000 |

765,770 |

kWh |

|

Lebensdauerverbrauch, 8 Jahre |

5,840,000 |

6,126,160 |

kWh |

|

Lebensdauer-Stromkosten, 0,1 EUR/kWh |

584,000 |

612,616 |

EUR |

|

Energieeinsparungen bei 8 Jahren Betrieb |

286,160 |

kWh |

|

|

Stromkosteneinsparungen bei 8 Jahren Betrieb |

28,616 |

EUR |

|

|

Energieeinsparung in Prozent |

5% |

||

Tabelle 1: Berechnung und Vergleich der USV-Stromkosten

Strategie 2: Routinemäßige PUE-Messung

Wie oben bereits erwähnt ist der PUE-Wert die wichtigste Kennzahl der Branche zur Messung der Energieeffizienz, vor allem wegen seiner Einfachheit und praktischen Anwendbarkeit. In einigen der betrachteten Branchen wird er jedoch kaum verwendet. Durch unregelmäßige Aufzeichnungen lässt sich kein genaues Bild der Energienutzung ermitteln, daher drängen viele Branchenexperten auf eine routinemäßige PUE-Messung, um die Schwankungen des PUE-Werts aufgrund von Jahreszeiten oder anderen Faktoren nachzuverfolgen. Um die Gesamtleistung in Echtzeit zu messen und den tatsächlichen PUE-Wert aufzuzeichnen, müssen PUE-Sensoren an Hauptmesspunkten installiert werden, um die tatsächliche Leistung zu messen (kW und kVA). Für beste Analyseergebnisse sollte auch der Energieverbrauch innerhalb eines bestimmten Zeitraums aufgezeichnet werden (Abb. 4).

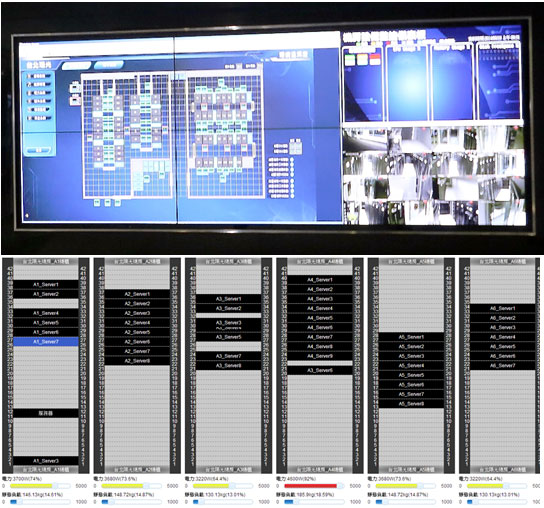

Abbildung 4: Dashboard für PUE-Überwachung

Strategie 3: Hardware-Aufrüstung und Verbesserung der Servereffizienz

Die Servereffizienz wirkt sich direkt auf den PUE-Wert aus und ist für seine Verbesserung von entscheidender Bedeutung. Für eine genauere Betrachtung der Servereffizienz müssen jedoch verschiedene Faktoren berücksichtigt werden. Zuerst einmal ist hier die CPU-Auslastung zu nennen. Bei CPUs mit schlechter Leistung kann der Einsatz von Virtualisierungstechnologie erheblich zur Steigerung der CPU-Leistung und Servereffizienz beitragen, ohne dass der Server ausgetauscht werden muss. In den Effizienzberechnungen sollten auch die Last und der Stromverbrauch für jedes Rack berücksichtigt werden. Blade-Server sind eine weitere Möglichkeit zur Erhöhung der Rack-Dichte (jedes Rack kann bis zu 1.024 CPU-Kerne aufnehmen) bei gleichzeitiger Senkung der Kühl- und Leistungsanforderungen.

Auch durch die Konsolidierung und Virtualisierung von physischen Servern lässt sich die Effizienz von Rechenzentren erhöhen, daher sollten die IT-Administratoren diese Faktoren bei der Hardware-Aufrüstung in Betracht ziehen. Studien haben gezeigt, dass die Konsolidierung von Servern folgende Vorteile bringt:

- Jährliche Einsparungen von bis zu 560 USD pro Server

- Weniger Wärmeerzeugung und entsprechend geringere Kühlkosten

- Freigabe von zusätzlichem Platz und Erweiterung der Verarbeitungskapazität

Es sollte jedoch darauf hingewiesen werden, dass der Nachteil von Virtualisierung und Blade-Servern der zusätzliche Wärme- und Kühlbedarf ist. Es sind verschiedene Lösungen im Einsatz, zu denen nun auch spezielle Techniken zur Luftführung gehören, wie zum Beispiel die Trennung von Warm- und Kaltgängen und die „Reihen-Kühlung“ (Abb. 5). Diese Maßnahmen sollen dem Problem einer zu hohen Dichte in Rechenzentren entgegenwirken.

Abbildung 5: Kaltgangeinhausung und Reihen-Kühlung für Rechenzentren mit hoher Leistungsdichte

Strategie 4: Verbesserung der Kühleffizienz von Rechenzentren

Nach der IT-Last ist die Kühlung der zweitgrößte Energiefresser. Die Installation eines Mechanismus zur Energieüberwachung und -messung ist daher entscheidend, um nachverfolgen zu können, wie sich die Kühlung auf den Gesamt-PUE und die Verbesserungsmaßnahmen auswirkt. Siehe die folgenden vier Techniken.

Der Google-Ansatz

Mit einem PUE-Wert von 1,12 ist Google einsamer Klassenprimus für grüne Strategien. Wie der neueste Bericht von Android Emotions enthüllte, sollen neue Google AI-Produkte den PUE-Wert noch weiter senken. Google hat in seinem Blog Efficiency: How others can do it (Effizienz: Wie andere etwas tun können) über die fünf wichtigsten Techniken berichtet, die von den Managern und Betreibern seiner Rechenzentren zur Reduzierung des PUE-Werts angewendet werden. Für eine Verbesserung der Kühleffizienz von Rechenzentren werden die folgenden drei Ansätze vorgestellt:

-

Steuerung des Luftstroms: Mithilfe einer ausgeklügelten Trennung von Warm- und Kaltgängen wird eine Vermischung von Warm- und Kaltluft vermieden, wodurch das Kühlsystem effizienter wird. Um Wärmestaustellen zu beseitigen und ein ideales Wärmemanagement zu erzielen, können Temperatursensoren an geeigneten Stellen installiert werden, um mithilfe von Computersimulationen Wärmestaustellen zu identifizieren und zu beseitigen. Eine EPA-Studie ergab, dass eine effektive Warm- und Kaltgangeinhausung den Energieverbrauch von Lüftern um 25 % und von Kühlgeräten um 20 % senkt.

Abbildung 6: Beispiel für Warmgangeinhausung -

Erhöhung der Umgebungstemperatur: Google hat den Mythos zerstört, dass Rechenzentren eine Temperatur von 21 °C benötigen, und vorgeführt, dass der Betrieb von Kaltgangeinhausungen bei 26 °C möglich ist. Eine Erhöhung der Temperatur bei gleichzeitiger Abschaltung von Nacherhitzern und Luftentfeuchtern sind kostengünstige Methoden zur Reduzierung des Energieverbrauchs.

- Freie Kühlung: In der Kühlungsinfrastruktur verbrauchen die Kühler in der Regel den meisten Strom. Wenn es die Wetterbedingungen zulassen, kann ein System zur freien Kühlung genutzt werden. Dabei wird kühle Luft von außen zugeführt und zur Kühlung genutzt, bevor sie wieder nach außen abgegeben wird. Weitere Möglichkeiten zur freien Kühlung: kühle Umgebungsluft, Wasserdampf oder der Einsatz großer Wärmespeicher.

Strategie 5: Erhöhung der Rechenzentrumstemperatur

In Bezug auf die Temperaturen in Rechenzentren galt lange der Grundsatz, dass sich IT-Administratoren stets einer Temperaturerhöhung widersetzen. Die neusten ASHRAE-Empfehlungen für die Betriebstemperaturen in Rechenzentren sehen jedoch einen Temperaturbereich von 18 °C bis 27 °C vor. ASHRAE hat auch den empfohlenen Feuchtebereich nach oben korrigiert. Die Änderungen bedeuten, dass Rechenzentren mehr Einsparungen bei den Kühlkosten erzielen und die Anforderungen für freie Kühlung besser erfüllen können.

Wenn die Temperaturregelung im Rechenzentrum zu konservativ ist und die Temperatur zu niedrig gehalten wird, erhöhen sich die Betriebskosten aufgrund des schlechteren PUE-Werts oder der erhöhten Kühlkosten. Laut einer Intel-Studie wird durch eine Erhöhung der Umgebungstemperatur im Rechenzentrum um 1 ℃ eine Senkung der Kühlkosten um etwa 4 % erzielt. Aus diesem Grund wurden verschiedene energiesparender Produkte für hohe Temperaturen entwickelt:

-

Energiesparende Hochtemperatur-Server: „Hohe Temperatur“ bedeutet, dass ein zuverlässiger Betrieb des Servers ohne Kühlung bei Temperaturen zwischen 5 °C und 47 °C möglich ist. Da der Server höhere Temperaturen im Rechenzentrum aushalten kann, ist weniger Kühlung erforderlich. Im Vergleich zu konventionellen Servern bieten energiesparende Hochtemperatur-Server eine hohe Temperaturtoleranz, niedrigen Stromverbrauch und einfache Bereitstellung. Sie können daher erheblich zur Erzielung von Energieeinsparungen im Rechenzentrum beitragen.

-

Hochtemperatur-Kühlsystem: Die Wärme in einem Rechenzentrum ist meist fühlbare Wärme, während der Anteil an latenter Wärme relativ klein ist. Das heißt, dass kaum Entfeuchtung erforderlich ist. Die Wassereinlauftemperatur für die Kühlanlage des Rechenzentrums kann höher als die üblichen 7 ℃ sein. Das bedeutet mehr Kühlung durch die Kältemaschine, verbesserte Energieeffizienz und höhere Energieeinsparungen bei der Klimaanlage.

Strategie 6: Einführung eines DCIM-Systems

Das DCIM-System (Data Center Infrastructure Management) wurde entwickelt, um den Managern und Betreibern von Rechenzentren eine effektivere und umfassendere Steuerung und Überwachung des Rechenzentrums zu ermöglichen. DCIM macht sich die Vogelperspektive beim Blick auf das Rechenzentrum zunutze, um IT-Administratoren bei der Planung, Verwaltung und Reaktion auf mögliche Risiken zu helfen und Ausfälle zu minimieren. Wie zuvor beschrieben ist eine niedrige Auslastung einzelner Server ein verbreitetes Problem in Rechenzentren. DCIM hilft den Administratoren von Rechenzentren bei der Erkennung von komatösen Servern und ihrer Neuzuordnung und kann somit zur Erzielung von Effizienzsteigerungen beitragen. Auch die Auslastung und der Energieverbrauch des Rechenzentrums lassen sich mit DCIM exakt messen.

Abbildung 7: Bildschirm einer DCIM-Schnittstelle für Wand- und Rackmanagement

Strategie 7: Verwendung sauberer und erneuerbarer Energiequellen

100 % saubere Energie ist ein ferner Traum, aber viele Unternehmen haben eine „hybride“ Strategie eingeführt, um diesem Ideal zumindest nahe zu kommen. Dazu gehört die Verwendung von erneuerbarer Energie, lokaler Stromerzeugung und Fernnetzen. IT-Giganten wie beispielsweise Apple haben 55.000 Solaranlagen installiert, eBay gewinnt aus Brennstoffzellen die Energie für seine Quicksilver-Anlage in Utah und Microsoft setzt auf Wind- und Sonnenenergie. Kleine und mittelgroße Unternehmen könnten mit ihren lokalen Versorgungsunternehmen kooperieren, um Zugang zu sauberem Strom oder erneuerbarer Energie zu erhalten. Sie können auch die Errichtung neuer Rechenzentren in der Nähe von sauberen Energieversorgern in Erwägung ziehen.

Schlussfolgerung

Die „Initiativen für grüne Rechenzentren“ erfordern viel Kreativität und sollten nicht durch konventionelle Denkmuster beschränkt werden. Es gibt unzählige Beispiele in der Industrie für eine Vielzahl von spürbaren Vorteilen durch grüne Rechenzentren. Der PUE-Wert kann als Kennziffer für die Messung von Energieeffizienz herangezogen werden und ist bei der Schaffung eines nachhaltigen grünen Rechenzentrums eine wichtige Größe. Alle IT-Giganten wie Google, Facebook, Apple und Microsoft haben Millionen in die Entwicklung von grünen Rechenzentren investiert. Es wurden außerdem optimale Lösungen für grüne Rechenzentren validiert, um einen idealen PUE-Wert zu erreichen. Die Branche ist sich darin einig, dass eine vollständige Prüfung der IT-Infrastruktur nötig ist. Normale Unternehmen können auch routinemäßige PUE-Messungen und Verwaltungstools (wie beispielsweise DCIM) verwenden, um Bereiche mit niedriger IT-Effizienz zu erkennen und zu korrigieren. Durch einen reduzierten Kohlenstoffausstoß und eine erhöhte Auslastung einzelner Server lässt sich die angestrebte PUE- und ROI-Optimierung erzielen.

Übersicht über grüne Energiestrategien und -techniken für moderne Rechenzentren

- 1080,79 Kb

Dokument-ID: WP0014_de-de

Übersicht über grüne Energiestrategien und -techniken für moderne Rechenzentren

- 1080,79 Kb

Dokument-ID: WP0014_de-deAutor: Delta Power Solutions

.gif)

.gif)